Nano banana pro 完全指南

Google DeepMind 開發者推廣大師維納德(Guillaume Vernade)在社群平台X上,發布了該模型的完整指南,強調 Nano-Banana Pro 已從上一代好玩性質的圖像生成,躍升為具備功能性的專業資產生產工具,適用於多種實用情境,從財報視覺統整、電影分鏡、房屋裝修等都能夠自己DIY。 動手前,先懂4個提示詞的黃金法則 Nano-Banana Pro 是思考型模型,能理解意圖與物理規則,維納德認為, 要達到最好的...

Google DeepMind 開發者推廣大師維納德(Guillaume Vernade)在社群平台X上,發布了該模型的完整指南,強調 Nano-Banana Pro 已從上一代好玩性質的圖像生成,躍升為具備功能性的專業資產生產工具,適用於多種實用情境,從財報視覺統整、電影分鏡、房屋裝修等都能夠自己DIY。 動手前,先懂4個提示詞的黃金法則 Nano-Banana Pro 是思考型模型,能理解意圖與物理規則,維納德認為, 要達到最好的...

About /关于模型 Z-Image 是由阿里云通义万相团队推出的一款高效文生图 AI 模型,其核心优势在于“Turbo”级的极致推理速度,能够在秒级时间内将文本描述转化为高质量图像,完美平衡了生成效率与画质表现,极大提升了 AI 创作的实时交互体验。 基于阿里云通义万相(Tongyi-MAI)团队的技术背景,Z-Image(特别是其 Turbo 版本)模型的主要特点可以概括为以下四点: 极致推理速度 (Turbo级) 核心特...

About 关于模型 FLUX.2 是 Black Forest Labs 于 2025 年 2 月发布的旗舰级 AI 图像生成模型,旨在将视觉生成从创意娱乐推向生产级工作流。该模型具备 4MP 摄影级超清画质与行业领先的 10 图参考一致性,解决了角色 IP 漂移与商拍细节不可控的痛点。FLUX.2 支持 JSON 空间控制、HEX 品牌色精准匹配及 32K 长文本理解,提供 Pro、Flex 和 Dev(开源)三版本。它是广告、UI 设计及虚拟制作领域实现高效视觉...

Gemini 可以通过对话方式生成和处理图片。你可以通过文字、图片或两者结合的方式向 Gemini 发出提示,从而以前所未有的控制力来创建、修改和迭代视觉内容: Text-to-Image::根据简单或复杂的文本描述生成高质量图片。 图片 + Text-to-Image(编辑):提供图片,并使用文本提示添加、移除或修改元素、更改风格或调整色彩分级。 多图到图(合成和风格迁移):使用多张输入图片合成新场景,或将一...

一、Nunchaku介绍 Nunchaku是由MIT Han Lab开发的4位扩散模型高效推理引擎,专为优化生成式模型(如Stable Diffusion)的推理速度和显存占用设计。结合SVDQuant量化技术,它在保持生成质量的同时显著提升性能。其技术优势如下: 显存优化:相比传统BF16模型,显存占用减少3.6倍(例如16GB显存设备可运行更大模型)。 速度提升:在16GB显存设备上,推理速度比16位模型快8.7倍,比传统4位量化(NF...

1.列出所有已安装模型 ollama list 2.安装/运行模型 ollama run XXXX 例如安装 deepseek:ollama run deepseek-r1:8b 3.删除模型 ollama rm XXXX 例如删除 deepseek:ollama rm deepseek-r1:8b 4.查看模型信息 Ollama show XXXX 5.启动 Ollama Ollama serve

模型介绍 作为Flux模型家族中的创新之作,Shutter Jaguar以其独特的四步生成流程,将文本转化为引人注目的电影级图像。这种革命性的AI技术不仅能够生成高度逼真的视觉内容,更通过Apache 2.0开源许可,为创意和应用提供了前所未有的自由度与可能性。 Shutter Jaguar 提供了 FP16 版本的同时,还提供了 FP8和 GGUF 量化版本,配置较低的电脑可以根据自身电脑配置选择对应版本 模型官方 F16下...

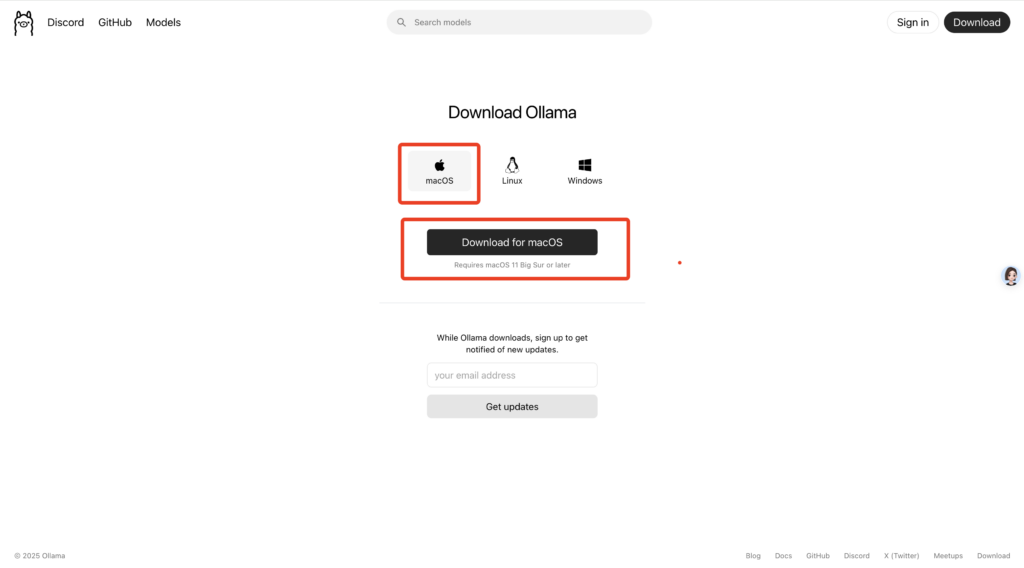

写在前面 在人工智能领域,大型语言模型(LLM)的应用日益广泛,但许多用户希望能够在本地环境中进行部署和运行,以满足特定的数据隐私、定制化需求或离线使用场景。 DeepSeek-R1 是最近非常火爆的一个高性能的 AI 推理模型,专注于数学、代码和自然语言推理任务。 Ollama 作为一种强大的工具,能够轻松帮助用户在本地环境实现大型语言模型(如 DeepSeek-R1)的部署与管理。本文将详细介绍如...

Flux 是Black Forest Labs(黑森林)团队发布的一个文生图大模型。 黑森林官网地址:https://blackforestlabs.ai/ 黑森林发布了Flux 的三个版本Pro,Dev和 schnell。 其中 Pro 仅支持API 调用,Dev 和 schnell 目前已开源。 1.Flux Dev 官方发布的Flux Dev只有 FP16 版本 建议 20g 显存以上的显卡 Flux Dev FP16下载地址:https://huggingface.co/black-forest-labs/FLUX.1-dev/...