写在前面

在人工智能领域,大型语言模型(LLM)的应用日益广泛,但许多用户希望能够在本地环境中进行部署和运行,以满足特定的数据隐私、定制化需求或离线使用场景。

DeepSeek-R1 是最近非常火爆的一个高性能的 AI 推理模型,专注于数学、代码和自然语言推理任务。

Ollama 作为一种强大的工具,能够轻松帮助用户在本地环境实现大型语言模型(如 DeepSeek-R1)的部署与管理。本文将详细介绍如何通过 Ollama 和 Open WebUI 在本地环境中实现 DeepSeek-R1 的部署与运行,同时为读者提供实际的操作指南和示例。

一.安装 Ollama

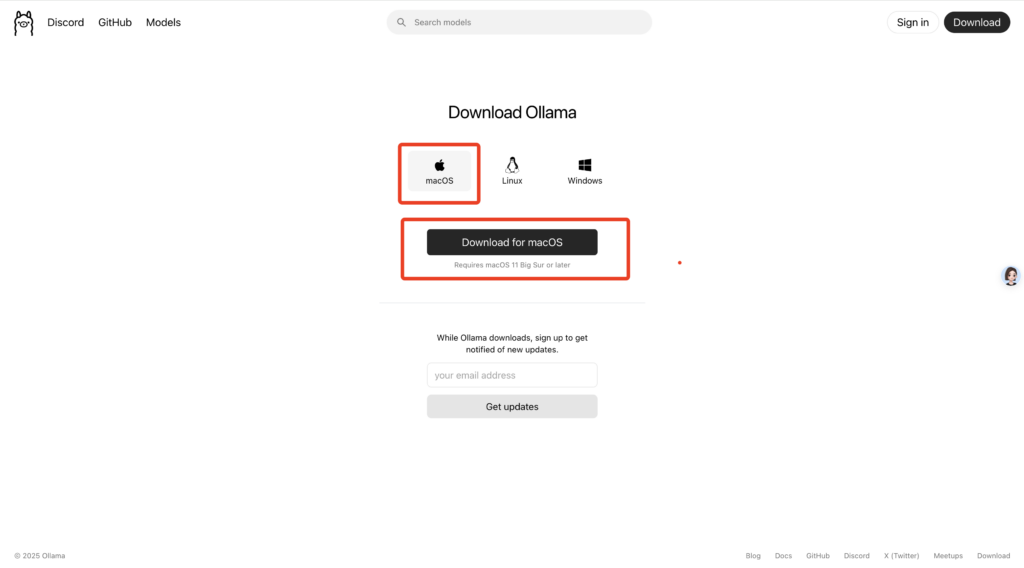

1.打开 Ollama 官网https://ollama.com/download,选择Mac 版本下载

2.打开下载好的安装包,按照默认设置安装即可

3.当右上角出现小羊驼时,即电脑上已成功安装并启动了 Ollama

二.安装模型

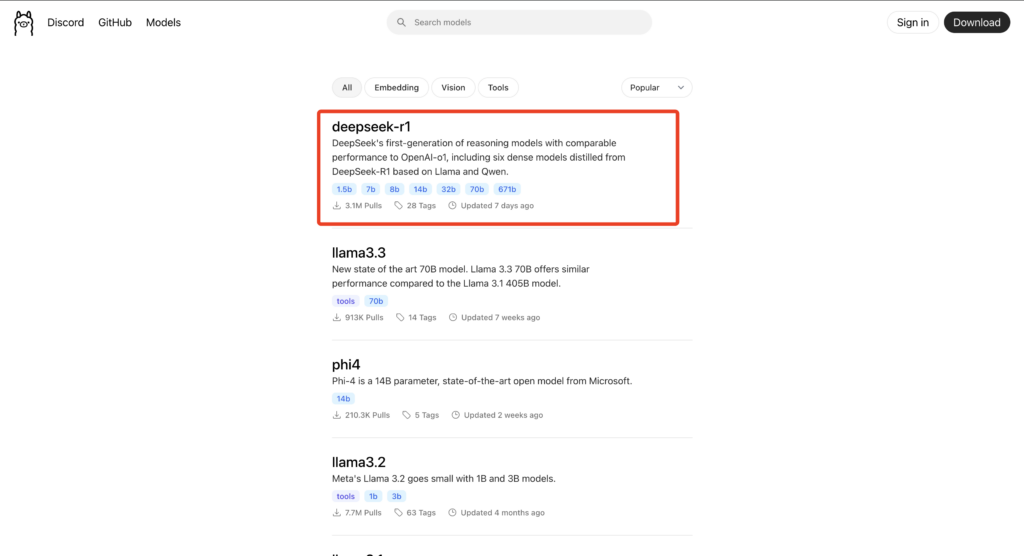

1.打开 Ollama 官网的模型库页面,选择打开 deepseek-r1

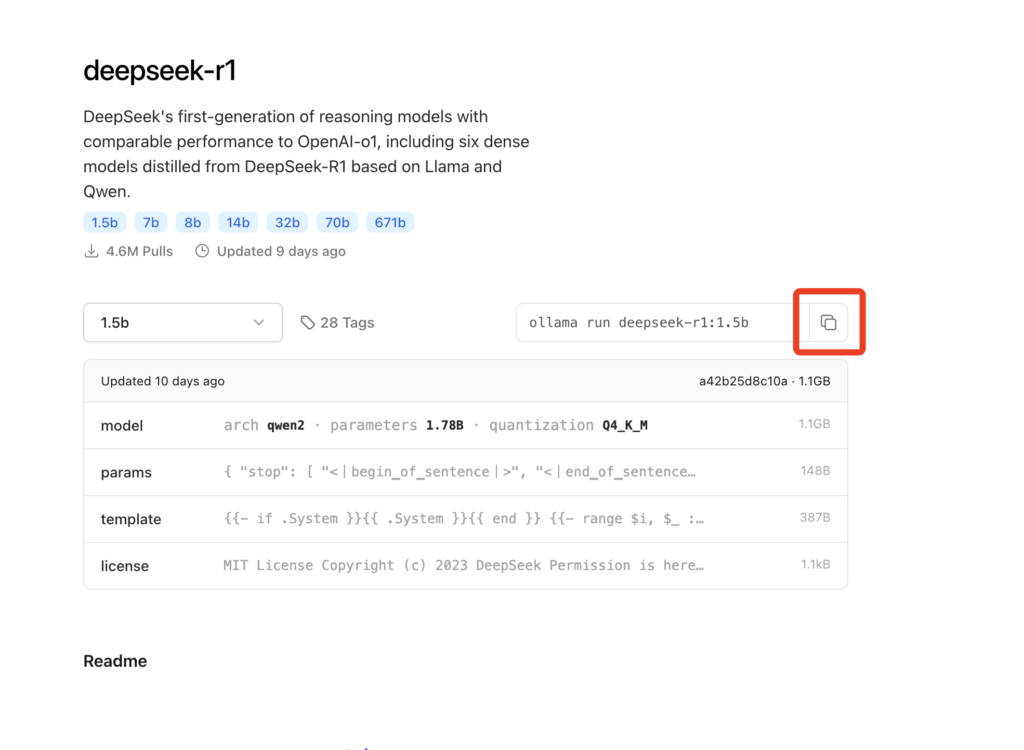

2.在 deepseek-r1 模型页面右上角选择要安装的版本,比如1.5B 或者 7B,这个还是要根据自身电脑的内存来选择

3.点击右侧的复制按钮

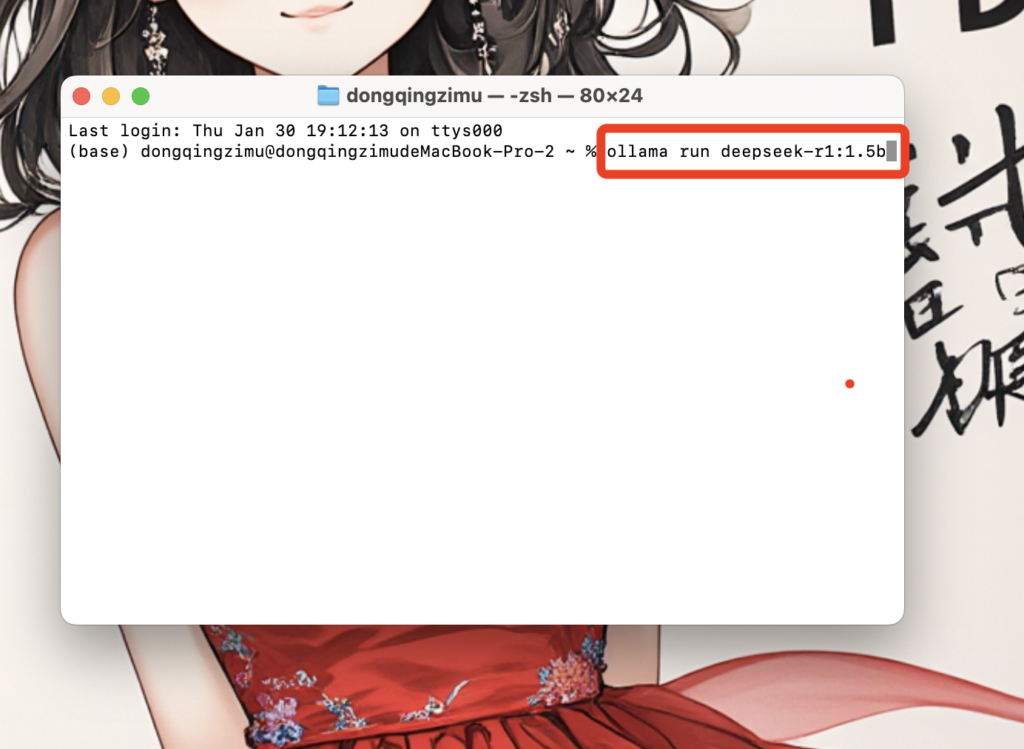

4.打开终端,粘贴上一步复制的内容,回车,即可完成模型安装。

5.安装完成后,即可在终端中和 DeepSeek R1 对话了。

接下来让我们来安装一个和ChatGPT 一样的可视化对话页面

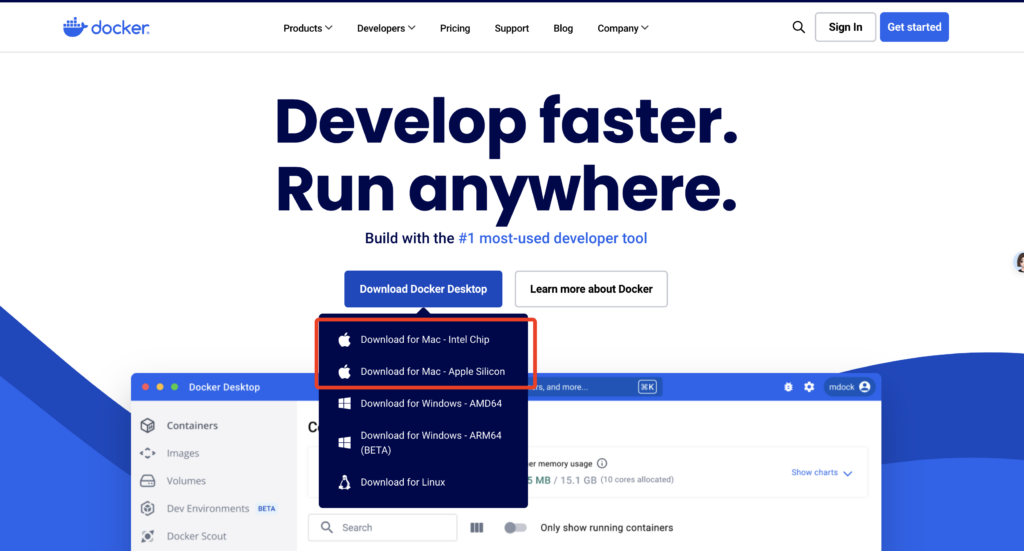

三.安装 Docker

1.打开 Docker的官网https://www.docker.com/,根据自己电脑芯片类型选择下载对应的版本

2.下载后,点击安装包打开安装程序,按照默认设置安装 Docker

四.安装 Open WebUI

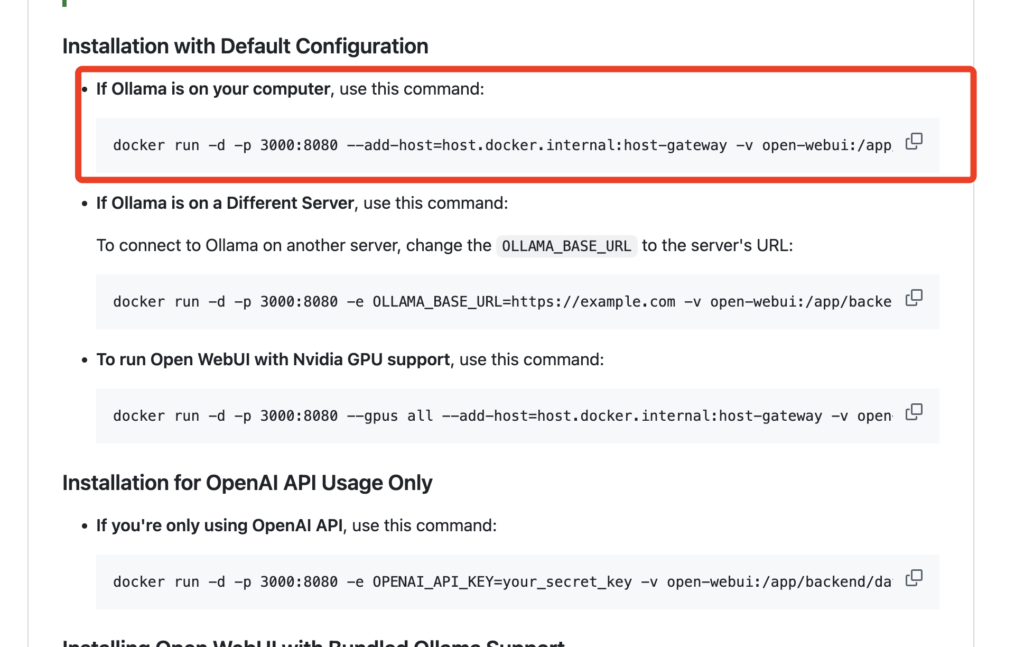

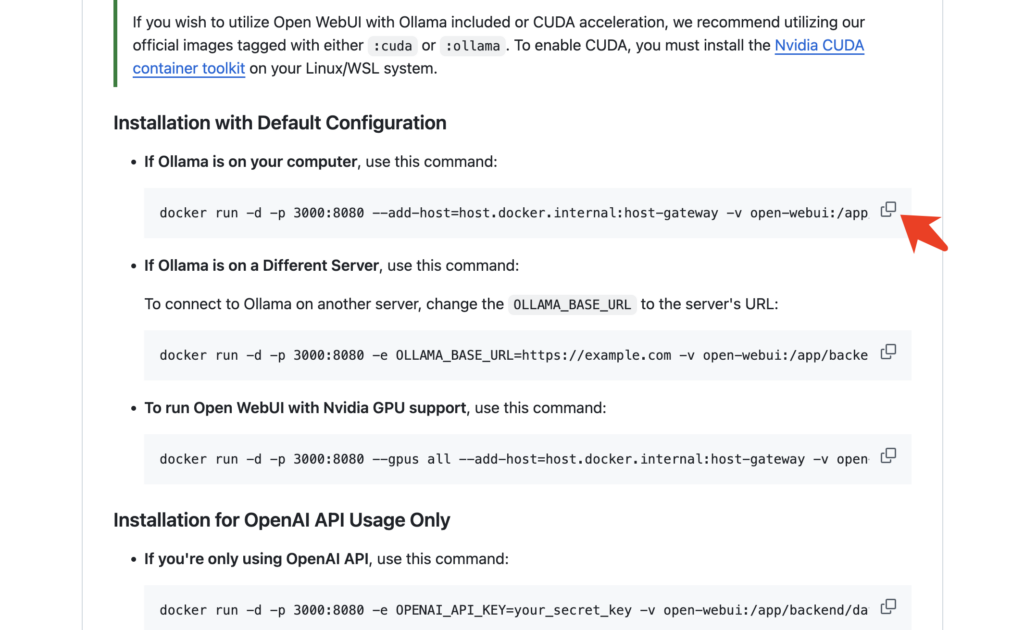

1.打开 Open WebUI 的 Github 页面https://github.com/open-webui/open-webui

2.我们之前已经安装了 Ollama,所以我们在 Github 页面中找到如下内容

2.点击右侧的复制按钮,复制对应的安装代码

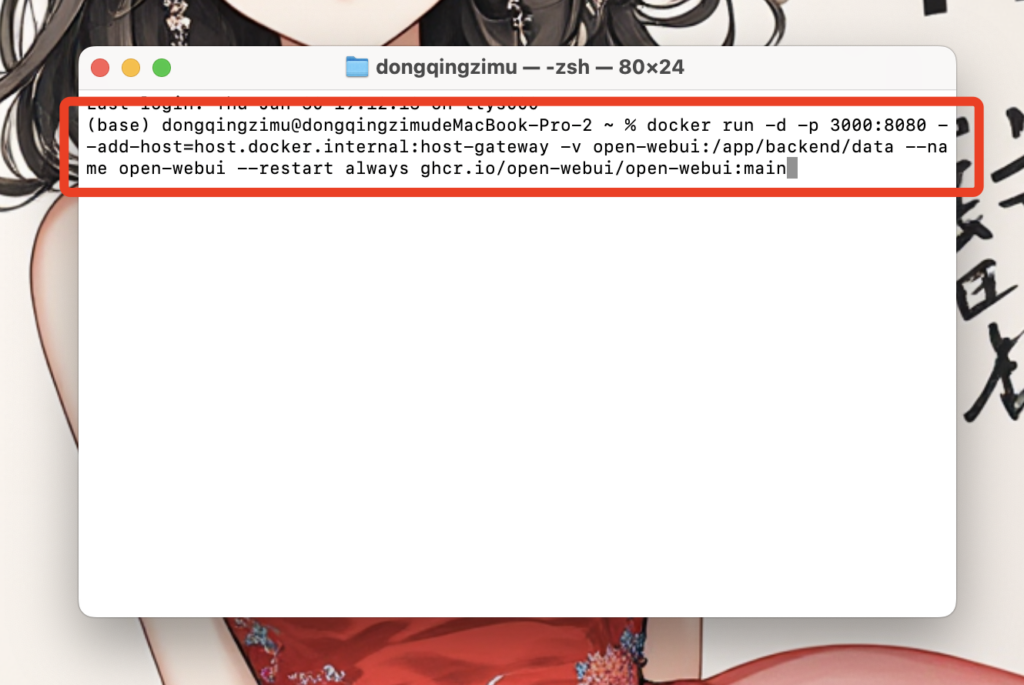

3.打开终端,将刚才复制的代码粘贴,回车运行安装即可

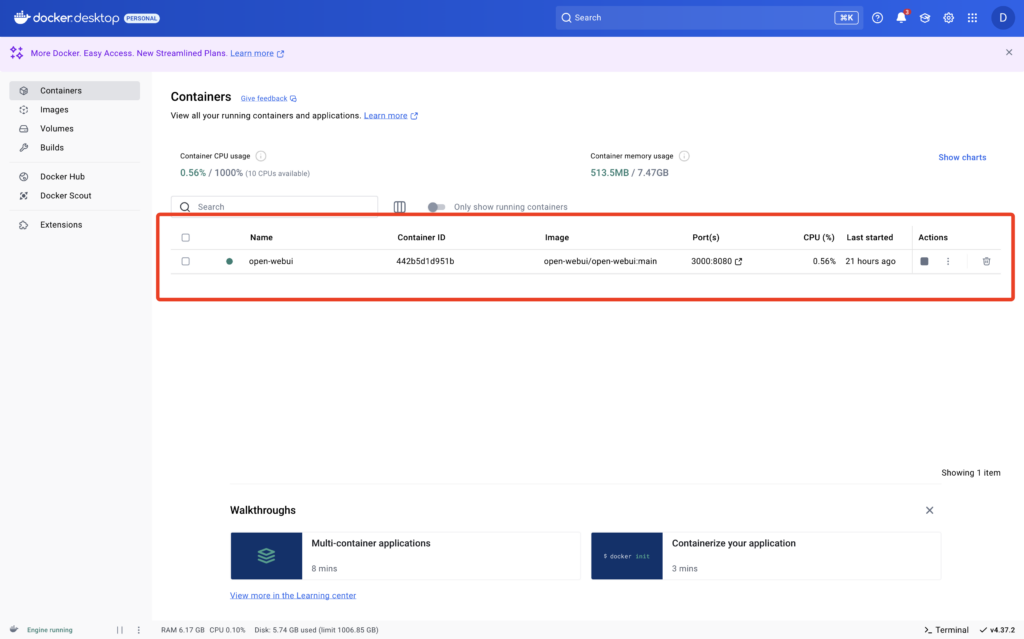

4.安装好了,在 Docker 里面可以看到 Open WebUI 已安装

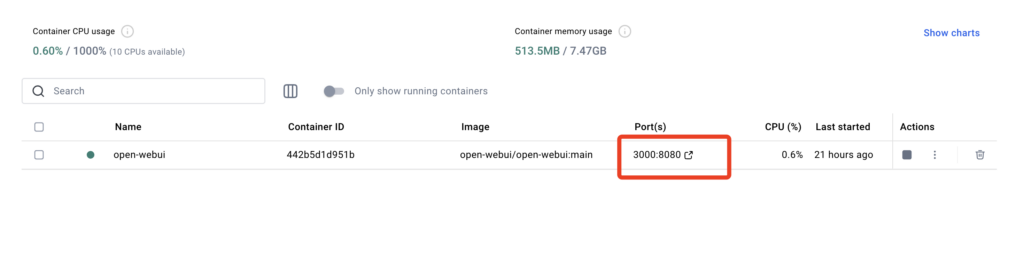

5.点击 Port 中的链接,打开Open WebUI

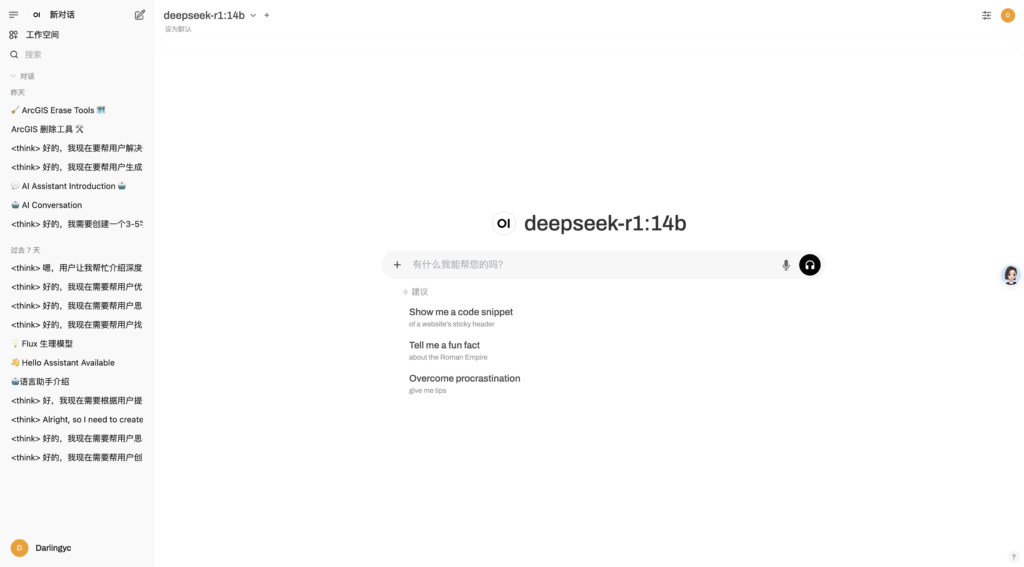

6.第一次打开 Open WebUI 会让输入邮箱和设置密码,这些信息都是存在本地的,用来登录使用的,设置成功后即可进入熟悉的 AI 对话页面

0 comments