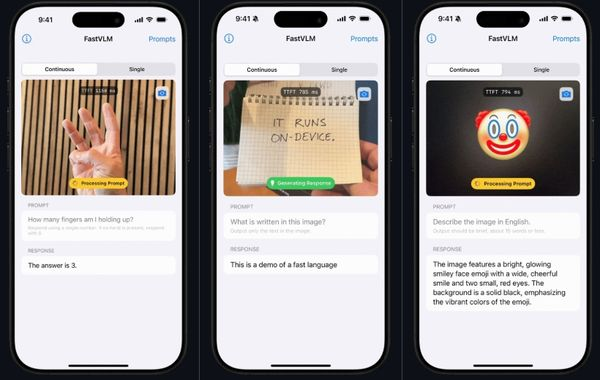

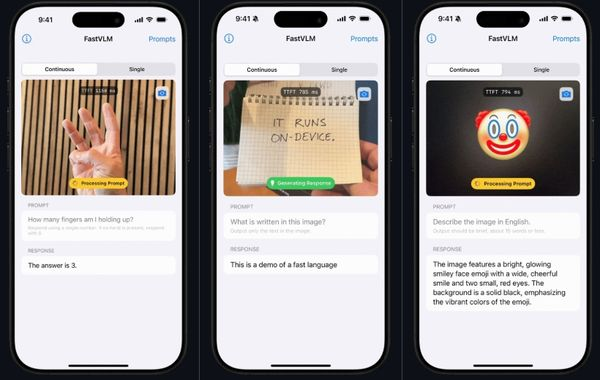

苹果正式发布 FastVLM 开源视觉模型,专为 iPhone、IPad 设备优化的高速视觉模型,强调能以极低的延迟完成图文理解任务,并实现与大语言模型 GPT 和 Qwen 高度整合。

FastVLM的主要功能是将高解析图像实时转换为语言模型可处理的视觉token,让设备得以在本地直接进行图像描述、问答分析等任务,无需仰赖云端资源或高耗能硬件。架构包含轻量级视觉主干FastViTHD,以及可与开源语言模型搭配的解码器模组。根据苹果公开的效能资料,从「看懂图片」到「即时语言输入」

苹果正式发布 FastVLM 开源视觉模型,专为 iPhone、IPad 设备优化的高速视觉模型,强调能以极低的延迟完成图文理解任务,并实现与大语言模型 GPT 和 Qwen 高度整合。

FastVLM的主要功能是将高解析图像实时转换为语言模型可处理的视觉token,让设备得以在本地直接进行图像描述、问答分析等任务,无需仰赖云端资源或高耗能硬件。架构包含轻量级视觉主干FastViTHD,以及可与开源语言模型搭配的解码器模组。根据苹果公开的效能资料,从「看懂图片」到「即时语言输入」

0 comments